No Bugs Wissen

Die Uhr tickt, die Bugs krabbeln: Von Lochkarten über 32-Bit bis zum 2038er-Fehler in der EDV-Zeiterfassung

Hallo Bugbuster-Freunde! Heute begeben wir uns auf eine faszinierende Zeitreise durch die Weiten der Computerzeit. Vom geheimnisvollen Zeitalter der Lochkarten über den Y2K-Bug bis hin zum 2038er-Fehler im EDV-Zeitstempel erforschen wir die geschichtsträchtigen Wendepunkte der Zeitmessung in der digitalen Welt.

Warum ist Zeitmessung in der EDV überhaupt so bedeutend? Die Antwort liegt in der Präzision, Effizienz und Synchronisation, die sie in Systeme und Prozesse einbringt. Jeder reibungslose Ablauf von Vorgängen, jede Transaktion von Geld, jedes Ereignis in der EDV basiert auf einer fehlerfreien Zeiterfassung.

Oder einfach erklärt: Damit euer Urlaubsantrag auch zur richtigen Zeit eingetragen wird.

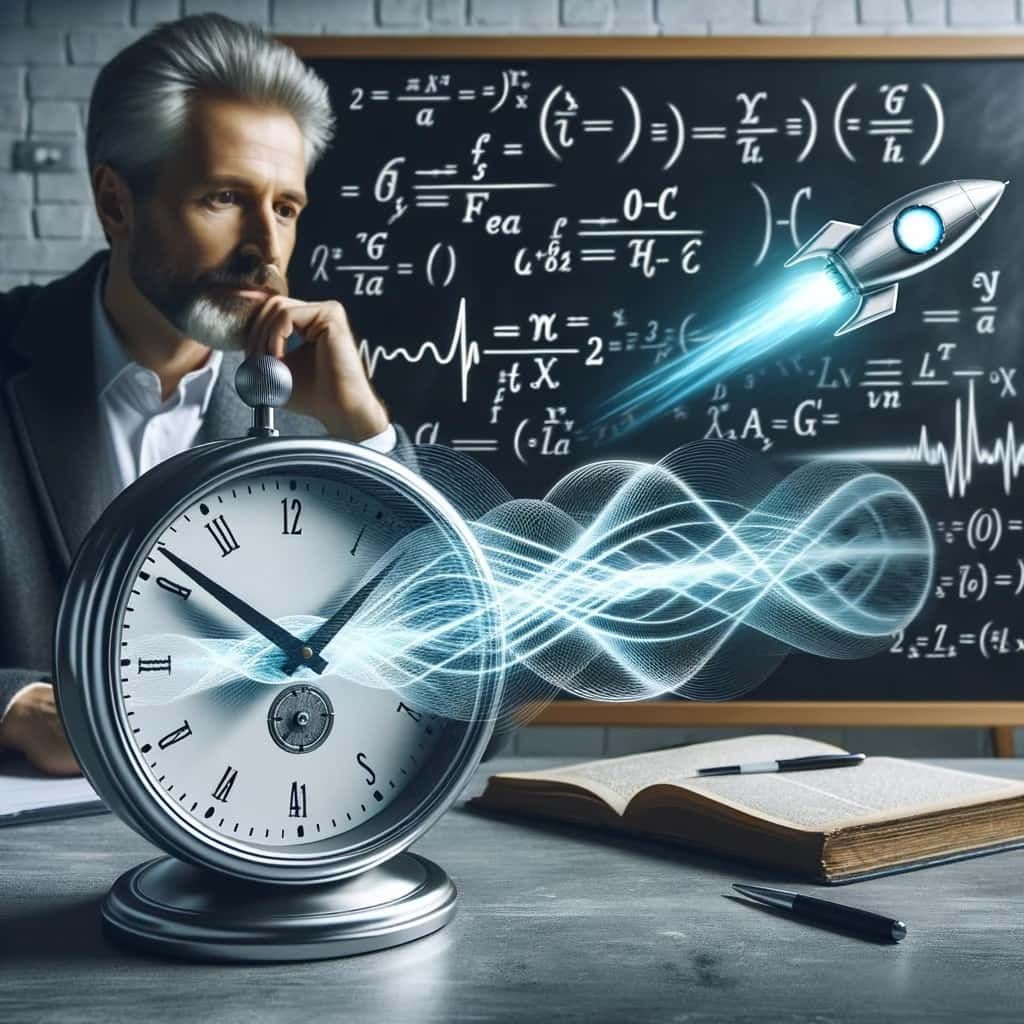

Die Ära der Lochkarten: Als wir Bits auf Lochpapier stanzten

Begleiten wir die Zeitreise zurück zu den Anfängen der Computerzeit, als Lochkarten die Sprache der Datenübertragung waren. Auf diesen perforierten Karten wurden Informationen durch Löcher codiert – eine einfache, aber geniale Form der Datenspeicherung. Hier schlägt das Herz der ursprünglichen Bit-Beschränkung, da jede Karte nur eine begrenzte Menge an Informationen tragen konnte. Dies führte dazu, dass nur die letzten beiden Ziffern des Jahres auf den Lochkarten vermerkt wurden, was einen raffinierten Kniff darstellte, um Raum zu sparen.

1998 = 98, 1999 = 99. Was ist bei 2000 = 00 oder ist es doch 1900?

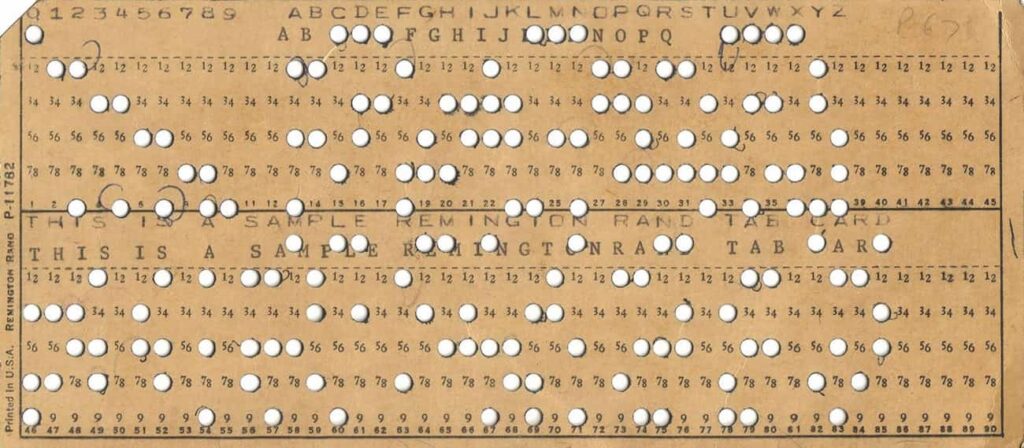

Das Jahr-2000-Problem: Der Y2K-Bug greift um sich (Century Date Change)

Nun begeben wir uns in das aufregende Jahr 2000, als die Computerwelt im Bann des Jahr-2000-Problems stand. Hier stieß die ursprüngliche Bit-Beschränkung der Lochkarten auf modernere Systeme, die das Jahr als vierstellige Zahl speicherten. Doch die Vergangenheit ließ grüßen: Viele dieser Systeme konnten die Jahrhundertgrenze nicht erkennen, was dazu führte, dass das Jahr 2000 als das Jahr 1900 interpretiert wurde. Wie ein Uhrwerk, das seine eigene Zeit verpasst, befanden sich die Computer in einem Dilemma.

Es wurde die Unixzeit eingeführt. Diese Zeitmessung stellt die Zeit in Sekunden dar, rückwirkend seit dem 1. Januar 1970, 00:00 UTC, als Ganzzahl in 32 oder 64 Bit.

Wir sehen, dass eine noch so geniale Idee vielleicht in der Zukunft nicht vorhersehbare Probleme bewirken kann.

Der 2012-Fehler: 23:59:60?

Kurz darauf betreten wir das Jahr 2012 und begegnen einem kleinen Bug, der „Schaltsekunde“ genannt wird.

Ein Tag hat 86.400 Atomsekunden in der koordinierten Weltzeit (UTC). Um die Abgleichung mit der Erdrotation zu gewährleisten, wird vom IERS (Internationaler Dienst für Erdrotation und Referenzsysteme) bestimmt, wann wir +1 Sekunde Abgleich durchführen.

Warum führen wir diese Schaltsekunde ein? Kurz gesagt: Die Erdrotation ist nicht konstant und wird durch den Mond, Vulkane und sonstige äußere Einflüsse verändert.

Diese Anpassung wurde nicht eingeführt, weil es technisch benötigt wird, sondern weil der 24h-Tag/Nacht-Wechsel immer 86.400 Sekunden hat.

Dieses scheinbar unscheinbare Ereignis, bei dem der 31. Dezember eine zusätzliche Sekunde erhielt, enthüllte jedoch überraschende Schwachstellen in Computersystemen und Softwareanwendungen.

Einige Systeme konnten die zusätzliche Sekunde nicht richtig verarbeiten, was zu unerwarteten Ausfällen oder Problemen führte. Dies lag daran, dass einige Softwareentwickler die Auswirkungen einer Schaltsekunde nicht vollständig berücksichtigt hatten.

Doch gibt es die Schaltsekunde nicht öfter?

Ja – sie wurde in den Jahren 2005, 2008, 2012, 2015 und 2016 hinzugefügt und hätte auch hier von den Systemen berücksichtigt werden sollen. Aber durch immer komplexere Programme kann es leicht passieren, dass so etwas übersehen wird.

Dieser Aspekt wurde 2012 den Banken zum Verhängnis, sodass niemand in der Lage war, Geld von Bankomaten abzuheben.

Das 2038er-Problem: Wenn Zeitstempel in Bits ertrinken

Und schließlich begeben wir uns in die Zukunft, wo der 2038er-Fehler auf uns wartet. In dieser Ära kollidieren die 32-Bit-Systeme erneut mit der Zeit und erreichen im Jahr 2038 ihre Grenze.

Was bedeutet das?

Das Problem tritt auf, wenn dieser Zeitzähler nicht mehr genügend Bits hat, um die Sekunden seit dem Startdatum abzubilden. Im Jahr 2038 wird die Anzahl der Sekunden 2.147.483.647 erreichen, was in einer 32-Bit-Darstellung nicht mehr darstellbar ist. Wenn das System nicht auf eine 64-Bit-Darstellung oder eine andere Lösung umgestellt wird, wird der Zeitzähler auf null zurückgesetzt, was zu Fehlfunktionen und unerwartetem Verhalten in vielen Anwendungen und Systemen führen kann.

Dies könnte zu einer Reihe von Problemen führen, wie zum Beispiel:

- Zeitstempel in Datenbanken könnten ungültig werden.

- Geplante Aufgaben und Zeitsteuerungen könnten versagen.

- Systeme, die Sicherheitszertifikate verwenden, könnten in einen fehlerhaften Zustand geraten.

- Logdateien und Zeitstempel in Anwendungen könnten unzuverlässig werden.

- Netzwerkprotokolle, die auf korrekten Zeitzählern basieren, könnten fehlschlagen.

Abschließende Gedanken: Eine Zeitreise durch die EDV-Geschichte

Unsere Reise durch die Zeit der EDV-Zeiterfassung zeigt, wie die Vergangenheit die Zukunft prägt und wie die Beschränkungen der Bits die Art und Weise beeinflussen, wie wir die Zeit messen. Von den Lochkarten bis hin zu modernen Systemen verbindet uns die ursprüngliche Bit-Beschränkung auf faszinierende Weise. Während die Technologie voranschreitet, ist es spannend zu sehen, wie unsere Zeitreisemaschinen sich weiterentwickeln und neue Horizonte erkunden. Lasst uns in die Tiefen der Computerzeit eintauchen und gespannt sein auf die Geschichten, die sie noch für uns bereithält!

Da wir ja nicht nur die Weltzeit (UT) haben, sondern auch die Astronomische Zeit (Lokale Sternenzeit).

Früher hatten wir sogar die Eisenbahnzeit – kleiner Side-Fact.

Kleine Aufgabe zum Nachdenken für die IT-Geeks:

Wie synchronisiert man die Zeit bei Reisen auf Mond und Mars? Der Mond bewegt sich mit ca. 3700 km/h um die Erde. Betrachtet von der Erde aus „relativ“ schnell. Ihr wisst, wo ich hin will – Einstein lässt grüßen.